ChatGPTに共有してはいけない8つの情報と共有してしまった時の対処法

4. パスワードやAPIキーなどの認証情報

システムへのアクセスに必要なID、パスワード、APIキー、秘密鍵などの認証情報を入力することは、攻撃者にシステムの扉を開ける鍵を渡すに等しい行為である。これらの情報が漏洩すれば、不正アクセスやデータ改ざん、システム停止など、壊滅的な被害につながる恐れがある。

5. 秘密保持契約(NDA)対象の情報

取引先や提携先と交わした秘密保持契約(NDA)によって開示が制限されている情報は、自社の機密情報と同様に厳重に扱わなければならない。契約内容の要約やレビューを依頼するなどの目的で入力した場合、契約違反となり、法的な紛争や損害賠償、信用の失墜を招くことになる。

6. 知的財産(著作権保護情報)

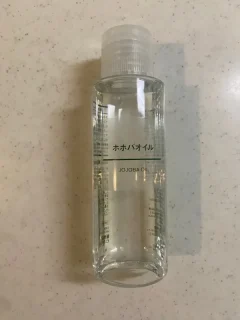

著作権で保護された文章、画像、音楽などのコンテンツを入力すると、AIが生成した内容にそれらが含まれ、意図せず著作権を侵害してしまうリスクがある。これにより、法的なトラブルや企業の評判低下につながる可能性がある。

7. 医療・法律・税務などの専門的かつプライベートな相談内容

個人の健康状態に関する医療情報や、法的なトラブルに関する相談内容、個人の資産状況に関わる税務情報などは、極めて機微な個人情報である。これらの情報を入力することは、重大なプライバシー侵害のリスクを伴う。特に医療情報に関しては、米国ではHIPAA(医療保険の相互運用性と説明責任に関する法律)などの厳格な規制が存在する。

8. 社内会議の議事録や非公開のコミュニケーション内容

社内での意思決定プロセスや、従業員間の率直な意見交換が含まれる会議の議事録、内部のチャットログなどは、外部に公開されることを前提としていない情報である。これらの情報を要約などの目的で入力すると、組織の内部情報や人間関係が漏洩し、組織運営に支障をきたす可能性がある。

漏洩を防ぐための多層的防御策

ChatGPTからの情報漏洩を防ぐためには、単一の対策に頼るのではなく、利用者個人、組織、そしてサービス提供者であるOpenAIの各レベルで対策を講じる「多層防御」のアプローチが不可欠である。

利用者個人ができる対策(基本防御)

日々の利用において、個々のユーザーが実践できる基本的な防御策が存在する。

- 学習設定のオプトアウト: 最も基本的かつ重要な対策は、ChatGPTの設定画面で「すべての人のためにモデルを改善する(Improve the model for everyone)」をオフにすることである。これにより、入力したデータがAIモデルの学習に利用されることを防げる。

- 一時チャット(Temporary Chat)の活用: 機密性の高い内容を扱う際は、「一時チャット」機能を利用することが推奨される。このモードでの会話はチャット履歴に残らず、モデルの学習にも使用されない。

- 強力なパスワードと多要素認証(MFA): アカウント乗っ取りを防ぐため、推測されにくい強力なパスワードを設定し、必ず多要素認証(MFA)を有効化する。これは基本的ながら極めて効果的なセキュリティ対策である。

- 定期的なチャット履歴の削除: 不要になったチャット履歴は定期的に削除することで、万が一アカウントが侵害された場合のリスクを低減できる。

- 情報の匿名化: どうしても機密情報に関連する内容を相談したい場合は、個人名や企業名を「A氏」「B社」のように置き換えるなど、情報を匿名化・仮名化する工夫が有効である。

組織・企業が講じるべき対策(組織的防御)

個人の注意喚起だけに頼るのではなく、組織として仕組みでリスクを管理することが重要である。

- 利用ガイドラインの策定と周知徹底: 何を入力してよく、何が禁止されているのかを具体的に明記した社内ガイドラインを策定し、全従業員に周知徹底することが不可欠である。定期的な研修を実施し、セキュリティ意識を高く維持することも求められる。

- 法人向けプランの導入: 「ChatGPT Enterprise」や「ChatGPT Business」といった法人向けプランは、入力データがデフォルトでモデル学習に利用されないことが規約で保証されている。さらに、シングルサインオン(SSO)や監査ログ、アクセス管理など、企業統治に必要なセキュリティ機能が提供されるため、ビジネス利用ではこれらのプランの導入が強く推奨される。

- API連携の活用: 自社システムとChatGPTをAPI経由で連携させる方法も有効である。API経由での利用では、入力データはモデル学習に使われない。これにより、自社のセキュリティポリシーに準拠した形で生成AIの機能を組み込むことが可能となる。

- 技術的対策の導入: DLP(Data Loss Prevention)システムを導入し、機密情報がChatGPTなどの外部サービスに送信されるのを自動的に検知・ブロックする仕組みを構築することも有効な対策である。また、CASB(Cloud Access Security Broker)やSIEM(Security Information and Event Management)を用いて利用状況を監視し、不審なアクティビティを検知する体制も重要となる。

OpenAIが講じているセキュリティ対策

サービス提供者であるOpenAIも、データの安全性を確保するために様々な対策を講じている。

- データ暗号化: 通信中のデータはTLS 1.2以上、保存データはAES-256という業界標準の強力な暗号化技術で保護されている。

- 第三者機関による監査: APIや法人向けプランは、SOC 2 Type 2などの第三者機関による監査を定期的に受けており、セキュリティ、可用性、機密性に関する統制が評価されている。

- バグ報奨金制度: セキュリティ研究者や倫理的ハッカーが脆弱性を報告することを奨励するバグ報奨金制度を設けており、外部の知見を活用してシステムの安全性を継続的に向上させている。

- インシデント対応体制: 24時間365日オンコール体制のセキュリティチームが潜在的なインシデントに対応する体制を整えている。

こうした対策は存在するものの、最終的な安全性はユーザーの利用方法に大きく依存する。提供されている機能を正しく理解し、組織のポリシーに従って利用することが、リスクを管理する上で最も重要である。

コメントはこちら